Çin istihbaratı, deepfake teknolojisinin potansiyel olarak yabancı istihbarat kuruluşları tarafından kullanılarak dezenformasyon yaratılabileceğine dikkat çekti. Deepfake, gerçek görüntü ve sesleri taklit ederek, kişileri veya olayları manipüle etme amacını taşıyan bir yapay zeka tekniğidir. Bu tür sahte içerikler, özellikle bilişsel savaş stratejileri için tehlike arz etmektedir. Bilgi savaşlarının hızla dijital platformlara taşınması, halkın güvenini sarsabilecek büyük bir risk oluşturuyor.

Deepfake Araçları Herkesin Erişimine Açık

Çin hükümeti, deepfake üretmeye imkan veren araçların sadece istihbarat birimleri tarafından değil, aynı zamanda bireysel kullanıcılar tarafından da kullanılabildiğine işaret etti. Bu araçların geniş bir kullanıcı kitlesine açık olması, potansiyel olarak devlet sırlarının, ticari bilgilerin ve kişisel verilerin çalınmasına neden olabilir. Bakanlık, vatandaşları bu tür teknolojilere karşı dikkatli olmaları konusunda uyardı ve şüpheli içeriklere karşı temkinli olmalarını istedi.

Devlet ve Ticari Bilgiler İçin Risk

Çin, vatandaşlarını deepfake teknolojisinin yalnızca kişisel güvenlik için değil, aynı zamanda ulusal güvenlik açısından da tehlike oluşturduğunu belirtti. Özellikle devlet sırları ve ticari bilgiler, bu teknolojinin hedefi olabilir. Bakanlık, devlet ve özel sektördeki hassas verilerin gizli yazılımlara aktarılmaması gerektiğini vurguladı. Ayrıca, şüpheli içeriklerin yayılmasıyla birlikte, bu bilgilerin yanlış ellere geçmesinin önüne geçmek için çevrim içi gizliliğin önemine dikkat çekildi.

Deepfake'in Yayılmasının Önlenmesi İçin Öneriler

Çin Devlet Güvenliği Bakanlığı, deepfake içeriklerinin yayılmasını engellemek amacıyla birkaç önlem önerdi. Öncelikle, gizli bilgilerin çevrim içi paylaşılmaması gerektiği, ayrıca şüpheli içeriklerin mutlaka yetkililere bildirilmesi gerektiği ifade edildi. Bakanlık, vatandaşları özellikle sosyal medyada karşılarına çıkan şüpheli sesli veya görsel içerikler konusunda temkinli olmaya çağırdı.

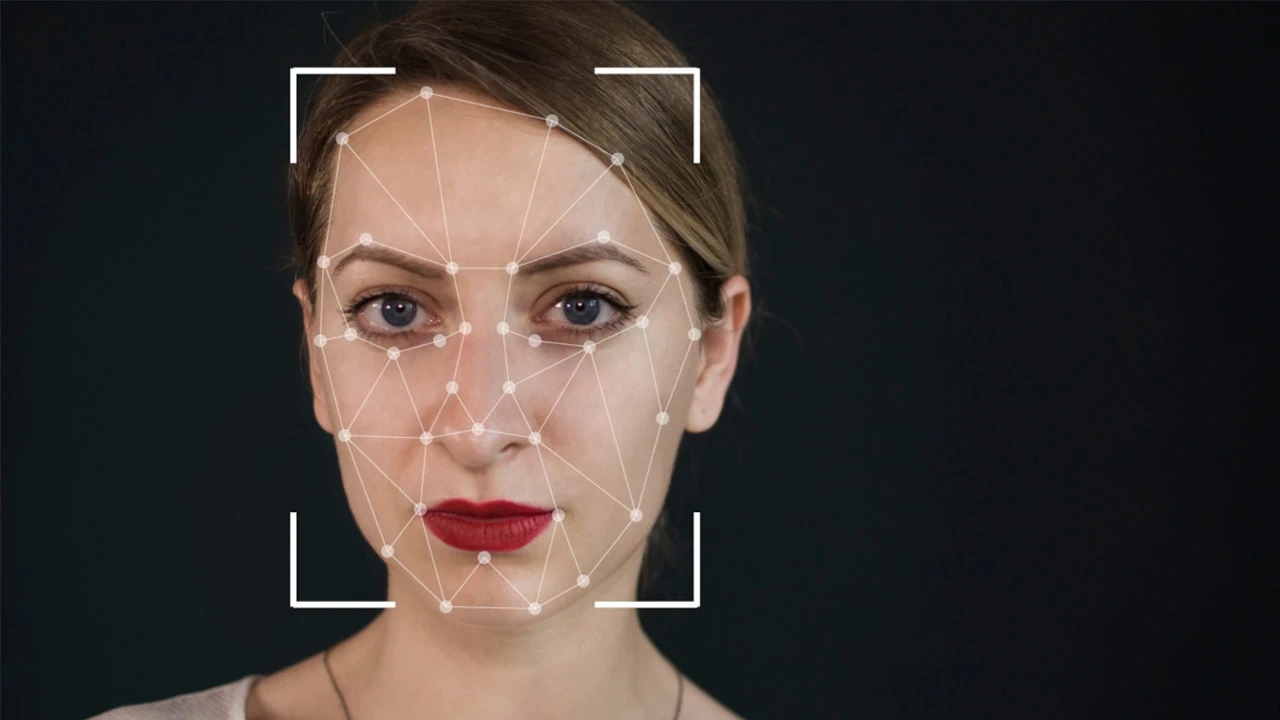

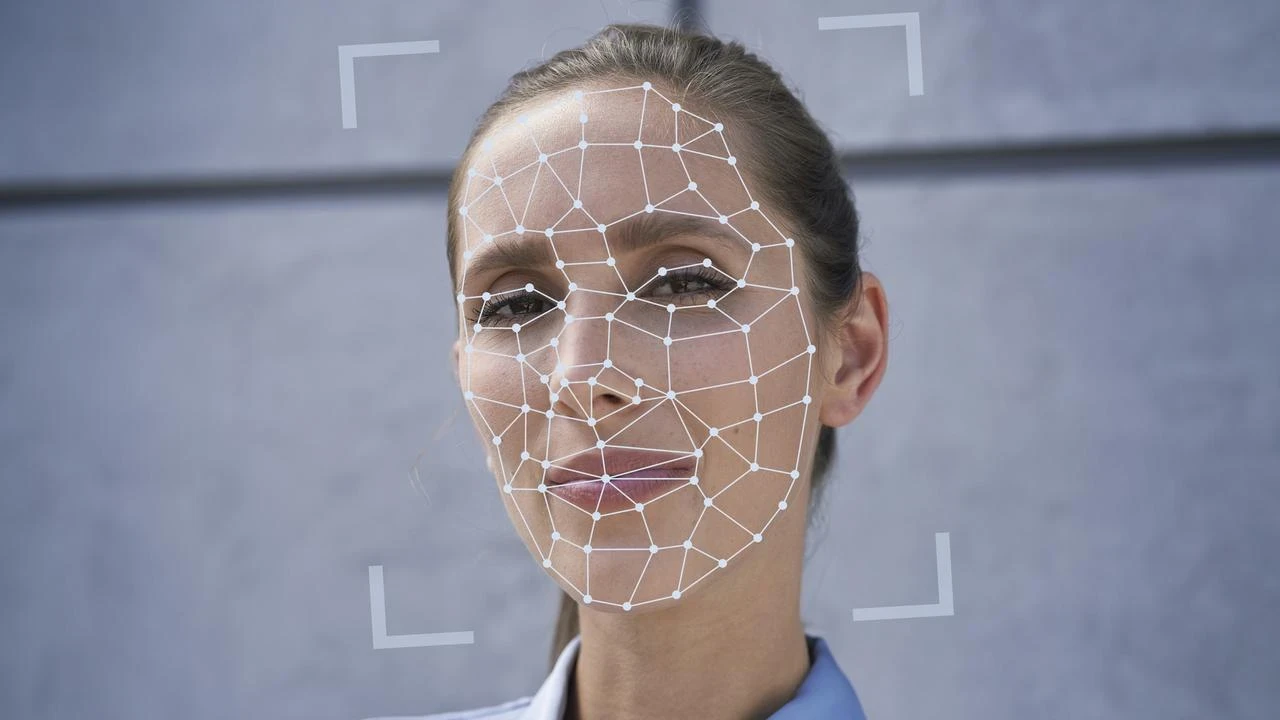

Deepfake Teknolojisinin Tanımı ve Çalışma Prensibi

Deepfake, "derin öğrenme" ve "sahte" kelimelerinin birleşiminden oluşan bir terimdir. Yapay zeka algoritmaları, mevcut görüntü ve sesleri taklit ederek gerçeğinden ayırt edilmesi zor sahte içerikler üretir. Bu teknolojinin potansiyeli, sadece bireysel düzeyde değil, büyük çapta manipülasyon yapabilme kapasitesine sahiptir. Medya ve kamuoyu üzerinde büyük etkiler yaratabilir.

Deepfake'in Tehlikeleri ve Geleceği

Çin istihbaratının uyarısı, deepfake teknolojisinin sadece bireysel güvenliği değil, aynı zamanda ulusal güvenliği tehdit edebileceğini gözler önüne seriyor. Bu teknoloji, sahte içerik üretmenin ötesine geçerek bilişsel savaş araçları olarak kullanılabilir. Vatandaşların bu tehlikeye karşı daha dikkatli olmaları, şüpheli içeriklere karşı önlem almaları ve güvenlikleri konusunda bilinçli olmaları, bu tehditlere karşı alınabilecek ilk adımlardır.